学习 NLP 的主要问题是缺乏适当的指导和域冗余。本文分享了一些最好的NLP开源数据集来解决这个问题!

在自然语言处理 (NLP) 中使用数据集

自然语言处理数据集:NLP 现在是一个令人兴奋的领域,尤其是在AutoNLP 和 Hugging Face这样的用例中,但它很难掌握。开始使用 NLP 的主要问题是缺乏适当的指导和领域过于广泛。很容易迷失在各种试图吸收所有内容的论文和代码中。

需要意识到的是,当 NLP 是一个广阔的领域时,你无法真正了解所有内容,但你可以尝试逐步取得进展。随着你的坚持,你可能会发现你比房间里的其他人都知道得更多。就像其他一切一样,这里的主要事情是采取这些渐进的步骤。

你需要采取的第一步是在数据集上训练你的 NLP 模型。创建自己的数据集需要大量工作,而且在刚开始时实际上是不必要的。

NLP数据集有哪些?每天都会发布无数开源数据集,重点关注单词、文本、语音、句子、俚语以及你能想到的任何其他内容。请记住,开源数据集并非没有问题。不幸的是,在抓取任何旧数据集进行测试时,你必须处理偏见、不完整的数据和一系列其他问题。

文本模型数据集:但是,网上有几个地方在整理数据集方面做得很好,可以更轻松地找到你要查找的内容:

- 带代码的论文- 近 5,000 个机器学习数据集已分类且易于查找。

- Hugging Face - 一个很棒的网站,可以找到专注于音频、文本、语音和其他专门针对 NLP 的数据集的数据集。

话虽如此,以下列表是我们推荐的一些开始学习 NLP 的最佳开源数据集,或者你可以尝试各种模型并遵循这些步骤。

1. Quora Question Insincerity 数据集

NLP开源数据集:这个数据集很有趣。在 Kaggle 上的这个 NLP 挑战中,我们提供了一个分类数据集,你必须在其中根据问题内容预测问题是否有毒。使这个数据集变得无价的另一件事是各种 Kaggle 用户的伟大内核。

在同一个数据集上有很多不同的帖子,如果你想从 NLP 开始,它们会很有帮助。

- 文章,文本预处理方法深度学习,包括预处理技术与深度学习模型,在这里我们谈论增加嵌入覆盖工作。

- 在第二篇文本分类的常规方法中,我们尝试带你了解一些已用于文本分类的基本常规模型,如 TFIDF、Countvectorizer、Hashing 等,并尝试访问它们的性能以创建基线。

- 你可以在注意力、CNN 和文本分类文章中更深入地研究深度学习模型,该文章侧重于解决文本分类问题的不同架构。

- 这是关于使用BERT和ULMFit 进行迁移学习的一篇文章。

2.斯坦福问答数据集(SQuAD)

文本模型数据集:斯坦福问答数据集 (SQuAD) 是源自维基百科文章的问答对的集合。

简而言之,在这个数据集中,我们给出了一个问题和一个文本,问题的答案就在其中。然后的任务是找出答案所在文本中的跨度。此任务通常称为问答任务。

如果你想更深入地研究,请查看使用 Hugging Face 理解 BERT文章,分享如何使用此数据集和使用 Hugging Face 库的 BERT 模型预测问题的答案。

3. UCI ML 药物审查数据集

自然语言处理数据集:你能根据药物审查预测疾病状况吗?UCI ML Drug Review 数据集提供患者对特定药物的评论以及相关条件和反映患者整体满意度的 10 星患者评级系统。

该数据集可用于多类分类,如 Using Deep Learning for End to End Multiclass Text Classification 中发布的那样,也可以尝试使用各种数值特征和文本来使用该数据集解决多类问题。

如果你想接触 NLP,这是一个很好的小型数据集。

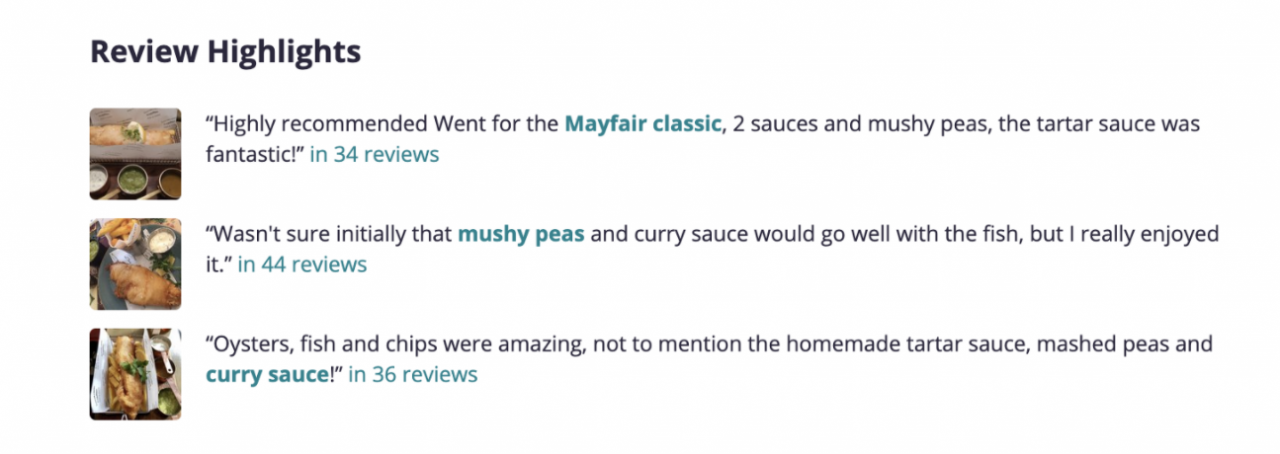

4. Yelp 评论数据集

NLP数据集有哪些?你喜欢食物并希望创建一个好的评论网站吗?

NLP开源数据集:此 Yelp 数据集可让你以 JSON 格式获取 Yelp 餐厅评论以及其他信息,例如类别、营业时间和关闭时间。人们可以尝试解决的问题之一是创建一个系统来将菜肴分类。或者将其用于命名实体识别 (NER) 以找出评论中的菜肴。你能否找到或创建一个系统来了解 Yelp 如何获取餐厅的评论亮点?

这也是了解 Yelp 业务和搜索的好数据集。你希望如何使用此数据集是无限的。

这个开源数据集包含 来自 8 个大都市区的8,635,403条餐厅评论。

5. IMDB 电影数据集

正在寻找下一部要观看的电影?该数据集包含来自 IMDB 的 5 万部电影的电影描述、平均评分、投票数、类型和演员信息。同样,这个数据集可以以多种方式使用,而不仅仅是从 NLP 的角度来看。使用此数据集的最常见方法可以是构建推荐引擎、类型分类和查找类似电影。

6. 20 个新闻组

自然语言处理数据集:二十个新闻组数据集包含关于二十个主题的大约 18,000 个新闻组帖子。主题多种多样,包括体育、无神论、政治等。

文本模型数据集:这是一个多类分类数据集,但你也可以使用它来学习主题建模,如使用 Python 中的 Gensim-LDA 的主题建模中所示。

7. IWSLT(口语翻译国际研讨会)数据集

NLP开源数据集:这个机器翻译数据集是用于翻译任务的事实上的标准,包含 TED 和 TEDx 演讲的翻译,涉及德语、英语、意大利语、荷兰语和罗马尼亚语的不同主题。这意味着你将能够在任何一对这些语言之间训练翻译。

另一个好处是它可以通过 PyTorch 使用 torchtext.datasets 访问。

NLP数据集有哪些?如果你想深入了解如何使用此数据集创建你自己的转换器,我们将介绍 BERT 转换器及其工作原理,你还可以了解有关如何使用 BERT 从头开始创建转换器的更多信息。你可以了解有关 NLP 的更多信息并解决各种任务,还有一些提供的途径可以让你使用这些数据集来解决问题。

祝你好运!